1.はじめに:顧客データ活用が進まない

「顧客データをもっと活用したい」という声をよく耳にします。購買データ、会員データ、来店履歴、キャンペーンの反応率など、日々さまざまなデータが蓄積されていますが、それらを活用して顧客理解を深め、顧客体験の向上や販促施策に結びつけていくことは簡単ではありません。

データが複数のシステムに散らばっていたり、分析担当者が不足していたり、情報システム部も本業の対応で忙しく、すぐに動けない場合もあります。「どこから手をつけたらいいかわからない」という状況のまま、時間だけが過ぎてしまうこともあります。

しかし、顧客データ活用が重要であることは間違いありません。そこでAWSが公開しているサンプルソリューションを活用することで、データ活用の最初の一歩を驚くほど軽やかに踏み出すことができます。

本記事では、主に小売業の皆さま向けに、「顧客データ活用の最初の一歩をどう簡単に始められるのか」をご紹介します。 今回ご紹介のデモンストレーションは小売業のシナリオですが、もちろん小売業以外でも営業・販売促進(マーケティング)・企画...といった職種の方々にお役に立てる内容です。また、「データ収集・加工・分析の依頼が多い...。」といったIT部門の方々の課題解決にもなります。 少しでも多くの皆様の参考になれば嬉しいです。

2.生成AIを利用した顧客データ活用基盤

2-1. データ活用のはじめの一歩

今回はAWSが公開している下記リポジトリを利用します。

https://github.com/aws-samples/sample-c360-text2sql-segmentation-entityresolution

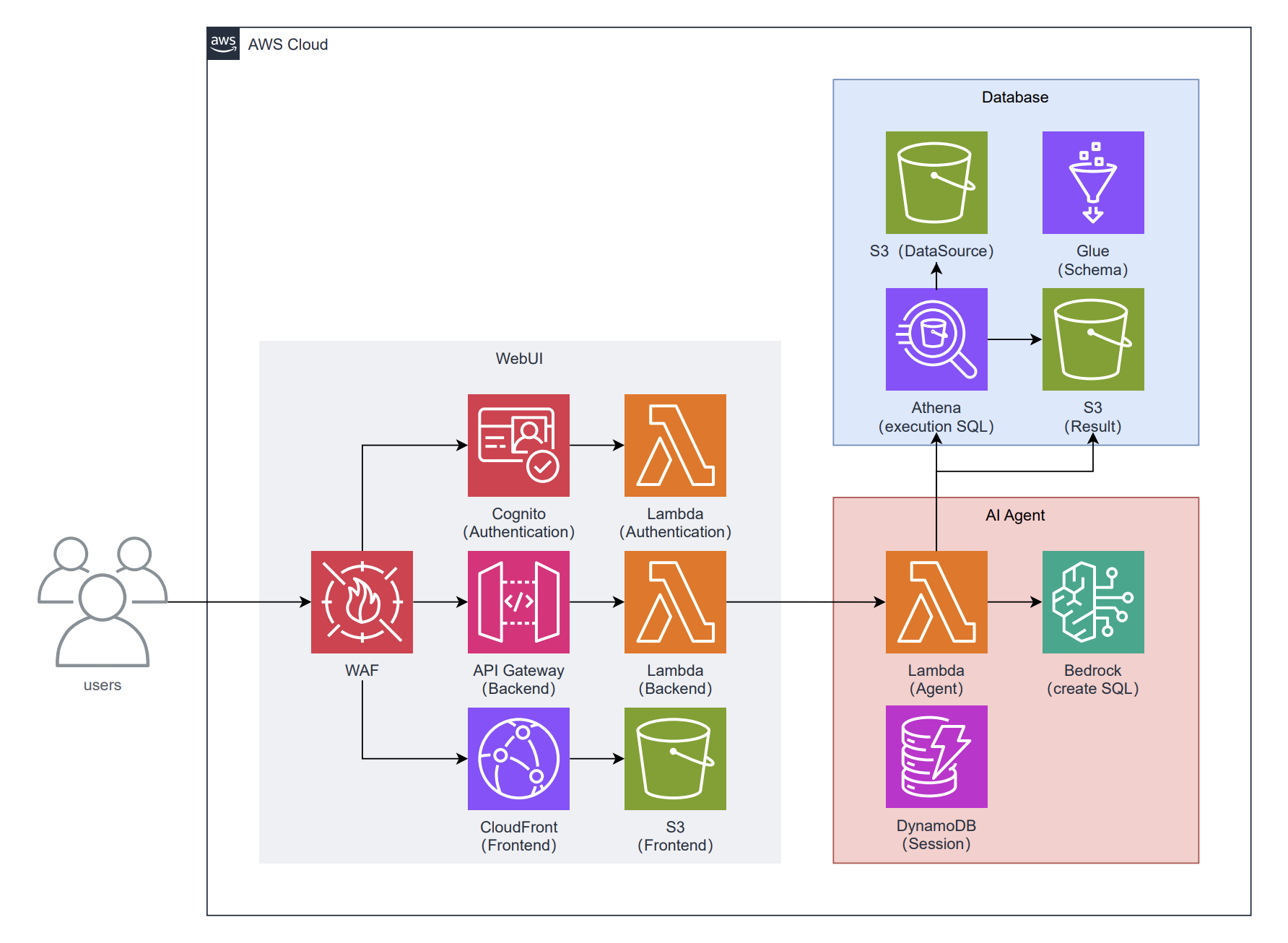

既にAWS Cloud Development Kit(AWS CDK)においてAWSリソースが定義されているので、CDKデプロイを実行するだけで下記「生成AIを利用した顧客データ活用環境」を構築することができます。

構築手順概要

- AWSアカウントを用意する

- EC2インスタンスにてVisual Studio Code Serverをセットアップする

- リモートリポジトリからソースコードを取得してくる

- CDKデプロイを実行する

2-2.具体的にAIエージェントは何をしてくれるの?

上記構成において、AIエージェントはデータ分析に使用する下記のようなSQL文を作成してくれます。

WITH customer_purchase_stats AS (

SELECT

cm.customer_id,

cm.email,

cm.firstname,

cm.lastname,

cm.gender,

cm.age,

COUNT(ph.item_id) AS purchase_count,

SUM(im.price) AS total_spent,

AVG(im.price) AS avg_purchase_price,

MAX(from_unixtime(ph.purchase_date)) AS last_purchase_date

FROM

customer_master cm

JOIN

purchase_history ph ON cm.customer_id = ph.customer_id

JOIN

item_master im ON ph.item_id = im.item_id

GROUP BY

cm.customer_id, cm.email, cm.firstname, cm.lastname, cm.gender, cm.age

HAVING

COUNT(ph.item_id) >= 2 -- 少なくとも2回以上購入している顧客に限定

)

SELECT

customer_id,

email,

firstname,

lastname,

gender,

age,

purchase_count,

total_spent,

avg_purchase_price,

last_purchase_date,

date_diff('day', last_purchase_date, current_timestamp) AS days_since_last_purchase

FROM

customer_purchase_stats

ORDER BY

avg_purchase_price DESC

LIMIT 50

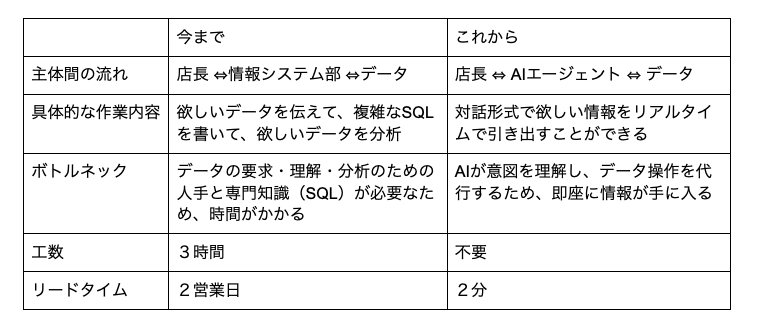

今までは、複雑なSQL文作成を情報システム部に依頼していたかもしれません。それでは、コミュニケーションコストや作業工数がかさんでしまいます。これからは、AIエージェントがSQL文を自動生成してくれるので、他部署とのコミュニケーションコストや全体的な作業工数を低減していくことができます。

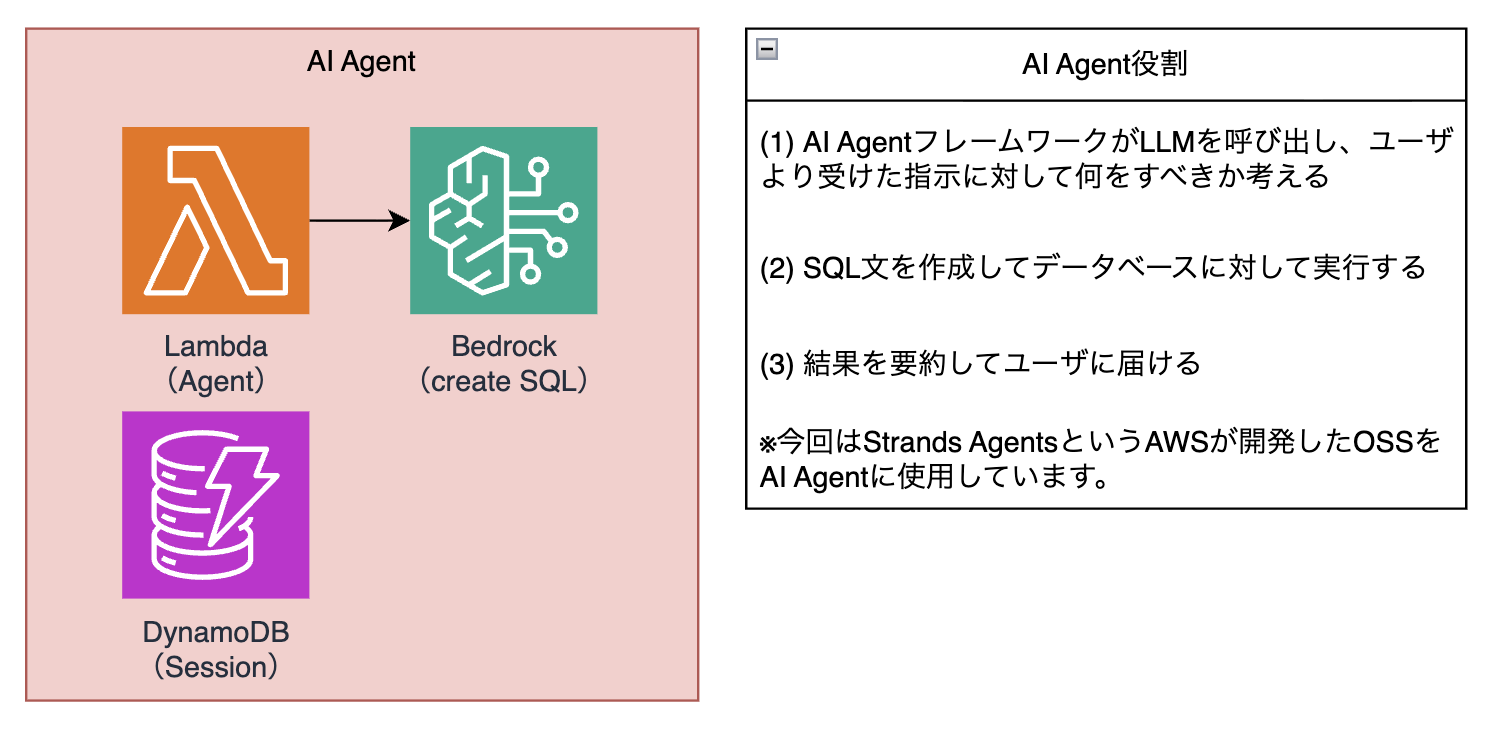

また、AIエージェントは下記役割も果たしています。

今までは、作成されたSQL文を分析ツール(Athena)に手動で流す必要や、出力結果を業務に使いやすい形にブラッシュアップする必要がありました。これからは、データ分析から要約までAIエージェントが対応してくれるので、業務効率が一層上がると思われます。

結果として、ビジネス部門が自走できる組織づくりを支援してくれるのです。

2-3.データベース層にはどんなデータが入っているの?

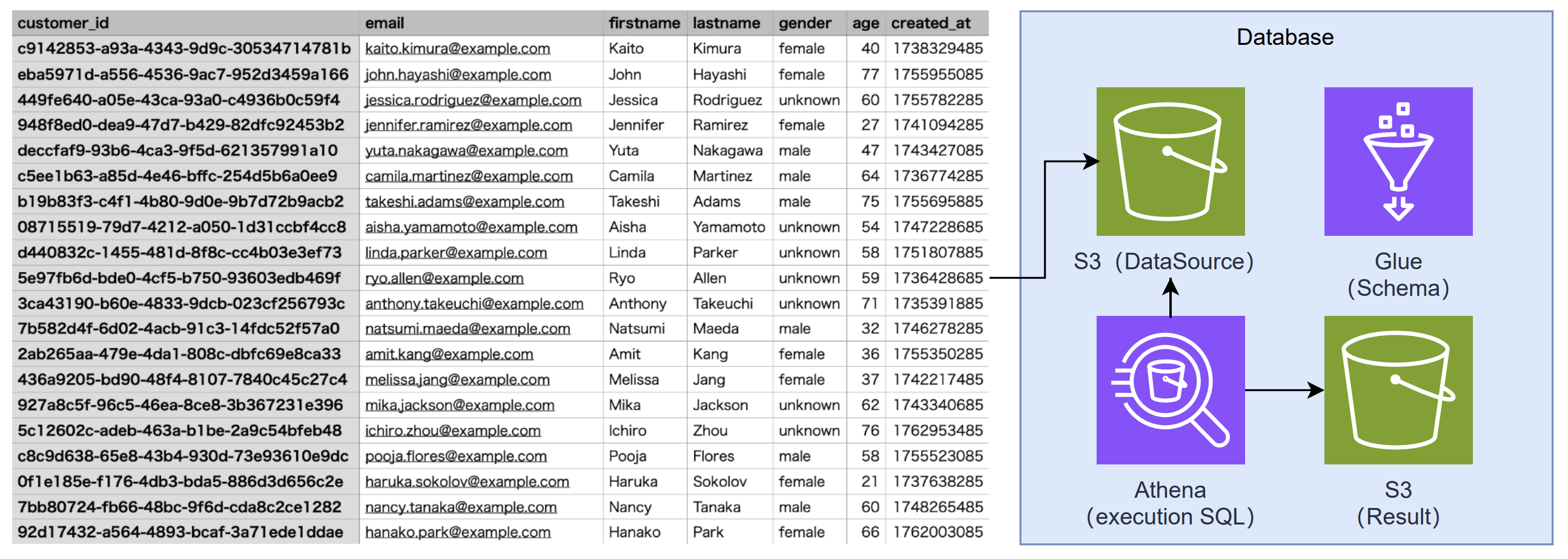

ここで使用しているテストデータを紹介いたします。今回は下記のようなCSV形式の顧客データをS3に格納しています。

本構成においては、S3に蓄積された顧客データをGlueで構造化していくことで、生成AIやSQLからすぐに活用できる分析基盤を構築しています。

3.AIエージェントで顧客データを分析する

生成AIを利用した顧客データ活用環境の構築ができれば、顧客データが分析できる状態まで整います。

3-1.どうやってAIエージェントを使えるの?

これまで、小売の現場で売上や購買傾向を調べるには、多くの手順が必要でした。期間を指定し、商品カテゴリごとに抽出し、必要であれば顧客データと結びつけ、場合によってはエンジニアに依頼して結果が出るまで待つこともありました。

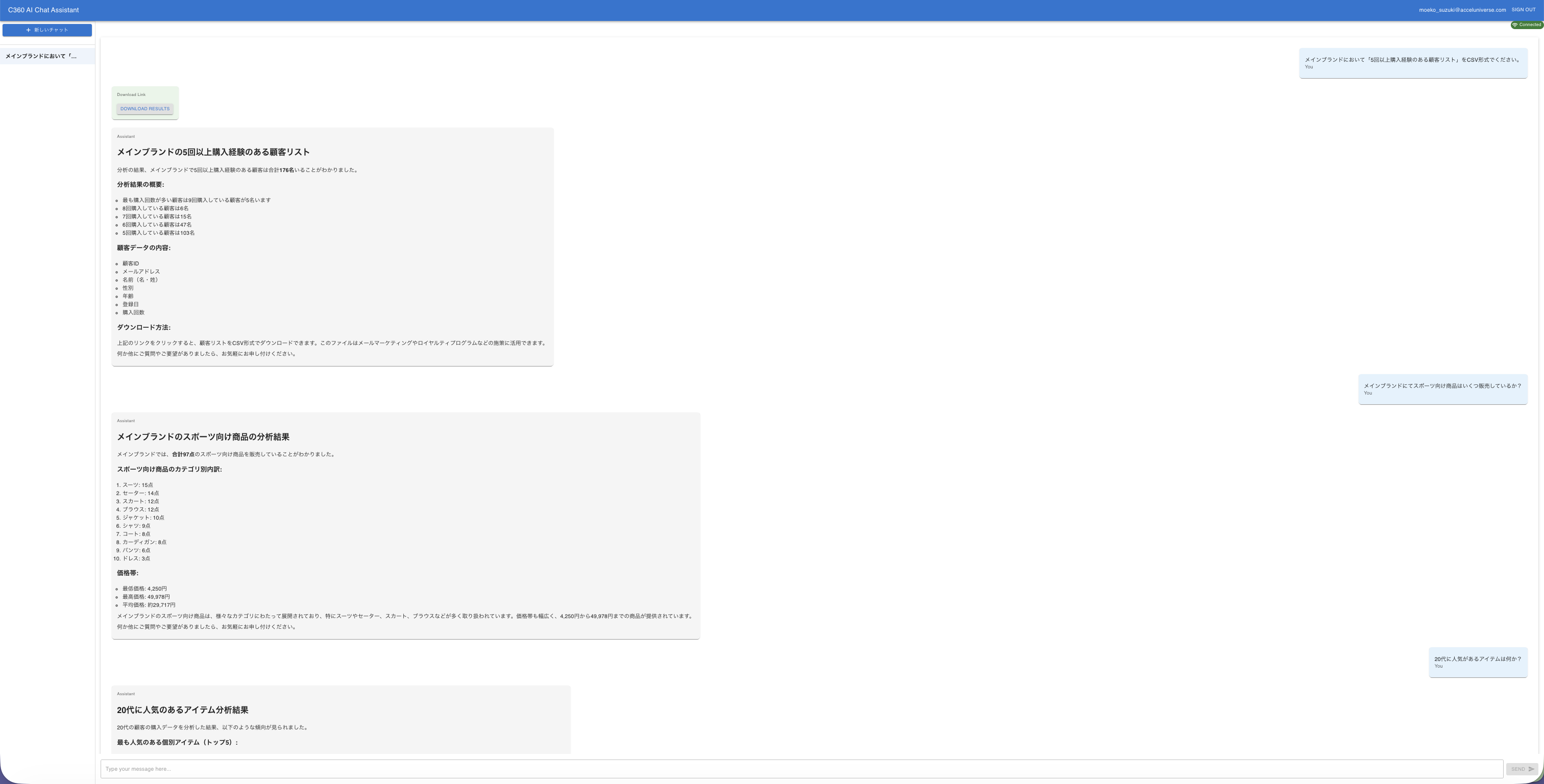

しかし、生成AIを使うと、自然な言葉で質問するだけで答えが返ってきます。

例えば次のような会話が可能になります。

AIエージェントと会話ベースでのやりとり

AIエージェントと会話ベースでのやりとり

質問すれば、意図に沿った情報に答えてくれるというのはとても魅力的です。

これまでは数日かかっていた問いが、わずか数秒で返ってくるだけではありません。すぐに次の問いが思い浮かぶようになります。

「では、その商品を購入している人のリピート率は?」

「購買が増える時間帯は?」

「他に一緒に買われている商品は?」

「天候との関係は?」

このように、問いが連鎖することで、現場の意思決定スピードが大きく向上します。

3-2.AIエージェントを使うメリット

こうした即時性のある分析が可能になると、現場だけでなく、情報システム部にとっても良い変化が生まれます。これまで情報システム部は、現場から依頼される「このデータを抽出してほしい」、「この条件で分析してほしい」といった作業に多くの時間を割いていました。依頼内容を確認し、必要なデータを探し、整形し、加工し、レポートとしてまとめるという一連の作業は、本来の業務とは別の大きな負担でした。

一方、ビジネス側も同じです。データを収集し、条件を合わせ、形式を整えるだけで多くの時間がかかり、肝心の分析や戦略検討に十分な時間を割けないという悩みがありました。しかし、生成AIが活用できる環境が手に入ると、こうした負担が大きく軽減されます。現場は、自分たちの言葉で質問し、その場で必要な情報を手にすることができます。

情報システム部は、繰り返し発生する抽出作業から解放され、より価値の高い本来の業務に時間を使えるようになります。

つまり、双方が本来注力すべき仕事に集中できるようになり、企業全体としての意思決定の質とスピードが大きく向上するのです。

例えば、以下のような活用方法が考えられます。

(1)販促担当:キャンペーンの効果測定

(2)フィットネス講師:退会リスクのある人にフォローアップ計画

(3)EC事業担当:実績を固定帳票とは違う切り口で分析

(4)小売店の店⻑:固定帳票を読み解けない経験の浅いスタッフの補助

(5)顧客分析担当:顧客のRFM分析(※1)、デシル分析(※2)、店舗エリア別分析etc

(6)経営戦略部:顧客データを活用した各事業の経営戦略

※1 RFM分析⋯顧客の購買データをRecency(最終購入日)、Frequency(購入頻度)、Monetary(購入金額)の3つの指標で評価し、顧客をグループ分けして最適なマーケティング施策(優良顧客への特別オファー、離反顧客へのアプローチなど)を打つための顧客分析手法

※2 テシル分析⋯顧客の購買データをもとに、購入金額の高い順に顧客全体を10等分(デシル=10分の1)し、各グループ(デシル1~10)の売上構成比や1人あたりの購入金額を分析する手法

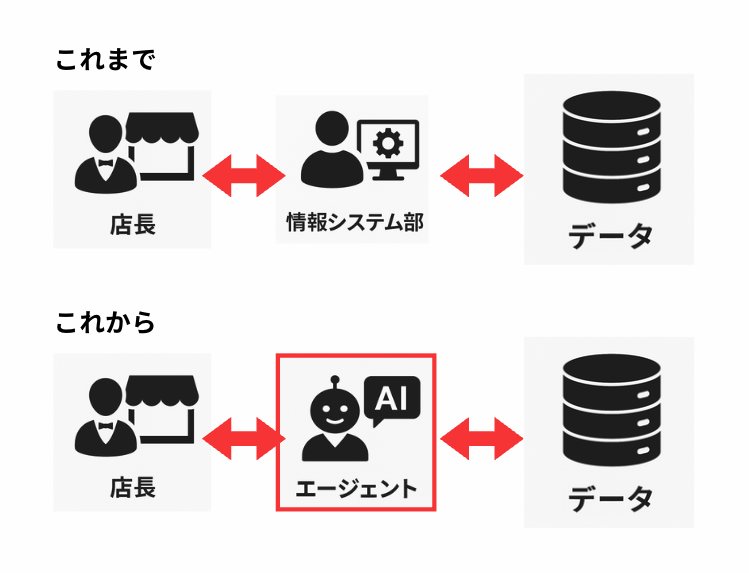

情報システム部→AIエージェント

情報システム部→AIエージェント

4.まとめ:スモールスタートで始める顧客データ活用

顧客データ活用は、大きな投資や大規模なプロジェクトが必要というイメージを持たれがちですが、実際には、サンプルソリューションを使ってまず体験してみることから始めることができます。複雑な準備や専門知識は不要で、必要なのは「やってみたい」という前向きな気持ちだけです。

アクセルユニバースでは、それぞれの小売企業が抱えている課題や状況に合わせて、サンプルソリューションのデモをご用意することができます。操作方法や仕組みについても、わかりやすい形で丁寧にご説明します。

また、「自社のデータならどう使えるのか」、「導入するとどこに効果がありそうか」といった疑問にも寄り添いながら、一緒に解像度を上げていくことができます。まずは、小さく触れてみることから始めてみませんか。顧客データ活用は、体験することで一気に実感できるようになります。気になる点や不安な点があれば、どんなことでもお気軽にご相談ください。

X(旧Twitter)・Facebookで定期的に情報発信しています!

Follow @acceluniverse