DEVELOPER’s BLOG

技術ブログ

その判断、誰が決めた?説明可能なAIをExplainable AI(XAI)で解説

0. 背景

「 特徴量の自動抽出 」を行うのがDeep Learningの強みの1つですが、与えられたデータに対する推論の過程が ブラックボックス化 され、なぜその特徴量を抽出したのか説明できないという問題点もあります。

例えば、自動運転技術が搭載されている車で事故が起こった場合、「 なぜ事故が起こったのか 」という原因の究明が難しく、実用化にあたり大きなハードルになっています。

最近の機械学習関連の学会では「 Explainability (説明可能性)」についての話題が増えています。この説明可能性については大きく2つ、「 法的な側面 」と「 技術的な側面 」があります。

法的な側面

先の自動運転の例で言うと、起きた事故について「 誰に責任の所在があるのか 」という問題が発生します。「AIを作った人間」に責任があるのか、それとも「AI本体」にあるのか説明出来なければなりません。

外部的な要請として「 AI利活用原則案・AI開発ガイドライン案 」などがあり、他にも「機械学習における公平性・説明責任・透明性」ワークショップFAT/MLが2014年から毎年開催され、国際的な議論もなされています。

技術的な側面

再び自動運転の例を挙げると、事故が起こる直前に、なぜその判断を下したのか「 判断の根拠 」をユーザーに分かりやすく提示しなければなりません。

技術的な面については米国のDARPAが XAI(Explainable AI) 研究開発投資プログラムを開始しており、機械学習に解釈性を持たせつつ精度を上げることを目的としています。

1.Explainable AI(XAI)のアプローチ

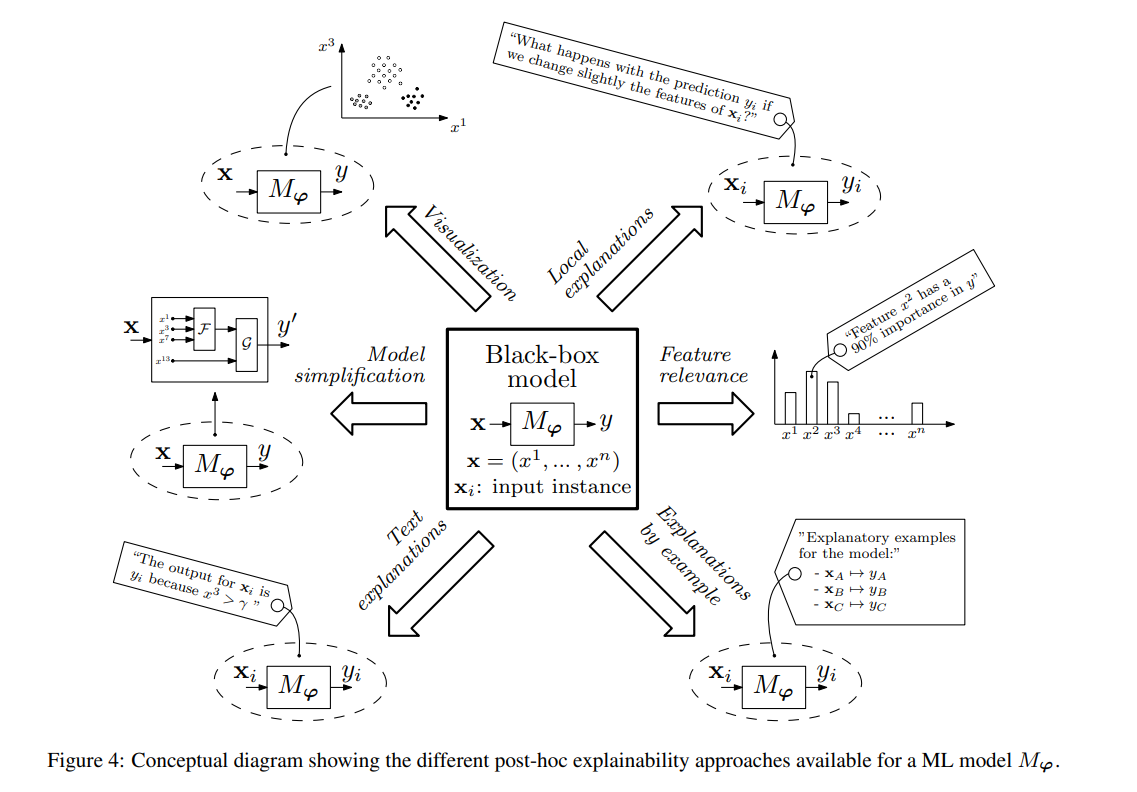

A Survey Of MethodsFor Explaining Black Box Modelの論文によると、XAIのアプローチは次の4つに分類できます。

- Black Box Explanation(解釈可能モデルの抽出) : AIをブラックボックスとして同等の解釈可能なモデルの生成

- Model Output Explanation(出力に対する説明の生成) : AIの出力に対し、予測の根拠を説明

- Model Inspection(ブラックボックスの中身の検査) : ブラックボックスの中身の説明

- Transparent Box Design(透明性のある学習器の設計) : AIの学習過程や構造を人間が解釈しやすくモデル化

それぞれのアプローチの概要を図示すると以下のようになります。

Explainable Artificial Intelligence (XAI): Concepts, Taxonomies,Opportunities and Challenges toward Responsible AIより引用

ではそれぞれのアプローチにおける代表的な技術を紹介します。

Black Box Model Explanation(解釈可能モデルの抽出)

代表的な例としてTrepan、G-Rexがあります。

Trepan

ニューラルネットワークbからからこれと等価な決定木を抽出します。具体的にはbに対して人工的なデータを流し、bの出力を得ながら決定木を構築します。

G-Rex

ニューラルネットワークbに対して、学習データである入力と出力の組み合わせからルールを出力します。学習データに少し摂動を加えたデータに対する出力もルールに組み込むことにより、学習データ以外の入力に対するbの振舞いも抽出できます。

Model Output Explanation(出力に対する説明の生成)

最も盛んに研究が進められているアプローチで、代表的な例としてLIME、Grad-CAM、SHAPがあります。

LIME(Local Interpretable Model-Agnostic Explanations)

データ一つに対する機械学習モデルの分類器による予測結果に対して、どの特徴に注目して分類が行われたかの説明をします。例えば、猫の画像認識を行うブラックボックスモデルにおいて、正しく判定されたデータに対して、入力データの特徴に該当する部分を少しずつ変更して結果を比較することで、どの特徴が判定に寄与したかを明らかにします。

Grad-CAM

まずCNNにおいて、入力データの画素の位置情報を最終畳み込み層まで保持させます。そして最後の判別出力への位置情報の影響度を得ることで、元画像上にホットスポット(影響の強い部分)を表示します。

SHAP

結果に対する特徴の貢献度を定量化します。これにより、ある特徴変数の値の増減が与える影響を可視化することが出来ます。例えば、口座が引き落とし不能になる確率を70%としたとき、"年齢=20歳"が25%、"職業=フリーター"が40%、"既婚"であることは-20%などのように、属性値ごとに予測値への数値としての寄与度に分解します。

Model Inspection(ブラックボックスの中身の検査)

代表的な例としてVEC、Prospectorがあります。

VEC

ブラックボックスの中身を見て、出力に対し入力がどのように影響を与えるかを、グラフを用いて可視化します。

Prospector

インタラクティブに入力を変えると、出力がどのように変わるかを示すアプリケーションをユーザーに提供します。

Transparent Box Design(透明性のある学習器の設計)

代表的な例としてFRLがあります。

FRL(Falling Rule Lists)

そもそも説明性のあるルールによる分類や診断技術に対して、各々のルールに正しさの確率を付与したり、ルールに優先順位を付けることにより、透明性がありかつ性能の高い学習器を設計します。

2.総論

ディープラーニングを使う機械学習では、「 特徴抽出の自動化 」により与えられたデータに対する推論の過程が「 見えない 」という問題があります。

ディープラーニングを用いた製品やサービスで事故や判断ミスなど重大な問題を引き起こした場合、原因の究明、改善が要請されます。その際に先述したようなブラックボックス化されているモデルの「説明可能性」に関する話題が増えています。

しかし、XAIには対象や目的に応じて上記のような様々なアプローチがあるので、個別企業だけでは研究開発をカバーしきれないという問題もあります。各国は、XAIを協調領域として国家プロジェクトとしても取り組んでいます。前出のDARPAのXAIのプロジェクトの他にも、国内ではNEDOの「次世代人工知能・ロボット中核技術開発」(人工知能の信頼性に関する技術開発)があり、2019年度は「説明できるAI」に関する7件が採択されました。

このような取り組みを皮切りに、私達もAIに関する問題を解決していきたいと考えています。

参考文献

AI白書2020

AI利活用原則案(総務省)

AI開発ガイドライン案(総務省)

Twitter・Facebookで定期的に情報発信しています!

Follow @acceluniverse